随着云计算技术的深入发展,云原生(Cloud Native)已成为构建和运行现代化应用的主流范式。它将应用的构建、部署、运维与底层基础设施解耦,强调弹性、可观测性和韧性。而在万物互联、实时响应需求日益增长的今天,云原生的理念与实践正加速向网络边缘延伸,深刻影响着边缘设备上的应用软件服务形态。

一、 云原生的核心与边缘的适配

云原生的核心通常围绕容器(如Docker)、编排(如Kubernetes)、微服务、服务网格(如Istio)和声明式API构建。这些技术旨在实现应用的敏捷开发、持续交付和自动化运维。

当这一套理念落地到边缘侧时,面临独特的挑战与机遇:

- 资源受限:边缘设备(如工业网关、车载终端、智能摄像头)的算力、内存和存储通常远不及云端数据中心。这意味着完整的Kubernetes发行版可能过于“笨重”,需要轻量化方案(如K3s、KubeEdge、MicroK8s)或更精简的运行时。

- 网络不稳定:边缘与云端、边缘节点之间的网络连接可能时断时续、带宽有限。这要求应用服务具备离线自治能力,能够独立处理本地数据与请求,并在网络恢复时进行高效的协同与同步。

- 分布式与异构性:边缘环境由海量、地理位置分散且硬件架构(x86, ARM)各异的设备组成。应用软件服务需要能够被统一地分发、部署和管理,同时兼容不同的运行环境。

- 实时性与数据本地化:许多边缘场景(如工业控制、自动驾驶)对延迟极其敏感,且出于隐私、法规或效率考虑,数据需要在本地或近端处理。这催生了“计算跟随数据”的模式,应用服务必须能够被动态调度到最合适的位置。

二、 边缘侧的应用软件服务新范式

在上述背景下,边缘侧的应用软件服务呈现出新的特点:

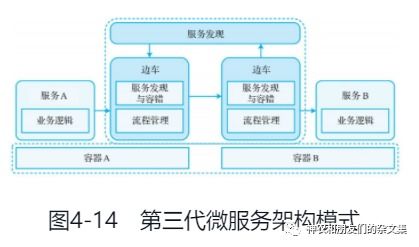

- 微服务的极致化与重构:传统的微服务在边缘侧可能需要进一步拆分或合并,以匹配单一设备的处理能力。服务间的通信协议可能更倾向于轻量级的MQTT、CoAP等,而非HTTP/REST。服务网格在边缘的部署模式也需简化,可能仅保留核心的流量治理和安全功能。

- 应用即“工件”,声明式部署:应用及其依赖被封装为不可变的容器镜像或更轻量的格式(如WebAssembly模块)。通过声明式的清单文件(如Kubernetes YAML),开发者可以定义应用在边缘集群中的期望状态——需要多少实例、部署在哪些节点(通过节点标签选择)、需要多少资源。边缘侧的编排器(如K3s Agent)负责自动拉取镜像、创建容器并维持状态。

- 混合编排与协同:典型的模式是“云端管控,边缘运行”。云端有一个集中的控制平面(如Kubernetes Master),负责应用编排、策略下发和全局视图;边缘节点作为工作节点,运行实际的服务负载。两者通过安全的通道通信,实现“一次定义,随处运行”。这为大规模边缘应用管理提供了可行性。

- 状态管理与数据服务:有状态应用在边缘的部署更具挑战。需要结合本地存储(如HostPath PV)、分布式存储方案或与边缘数据库(如SQLite、EdgeX Foundry)集成。数据服务可能需要具备流处理、本地缓存和向云端批处理同步的能力。

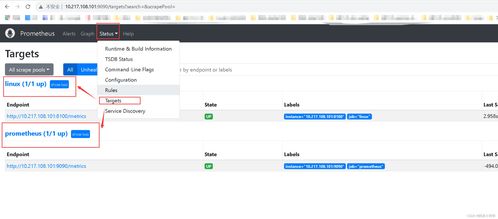

- 安全与生命周期管理:边缘设备暴露在物理不可控的环境中,安全至关重要。这包括容器镜像的安全扫描、运行时的安全隔离(如Seccomp, AppArmor)、服务间的mTLS认证,以及设备本身的身份认证与准入控制。应用服务的全生命周期(监控、日志收集、自动伸缩、滚动更新)也需在资源约束下实现。

三、 实践观察与展望

在实践中,我们看到:

- 轻量化K8s发行版成为主流桥梁:K3s等项目成功地将K8s的API和管理能力带到了资源受限的边缘,是当前实现边缘云原生应用服务的关键技术栈。

- Serverless理念的渗透:事件驱动的函数计算(如OpenFaaS在边缘的部署)为某些边缘数据处理场景提供了更简洁的编程模型,进一步抽象了基础设施。

- 标准化与开源生态的演进:LF Edge旗下的Akraino、EdgeX Foundry等项目正致力于构建边缘计算的开源框架和标准接口,推动应用服务的互操作性。

- AI模型作为特殊服务:在边缘侧,训练好的AI模型常被封装为独立的推理服务(通过容器或专用运行时),通过服务网格进行调用,实现智能的本地化。

随着5G、算力网络和硬件虚拟化技术的发展,边缘设备的能力将持续增强。应用软件服务将更加智能化、自适应和自治,能够根据网络条件、负载情况和业务需求,在云、边、端之间无缝迁移和协同,真正实现无处不在的智能计算。对于开发者而言,掌握云原生技术栈,并深刻理解其在边缘环境的变体与约束,是构建下一代分布式应用的关键。